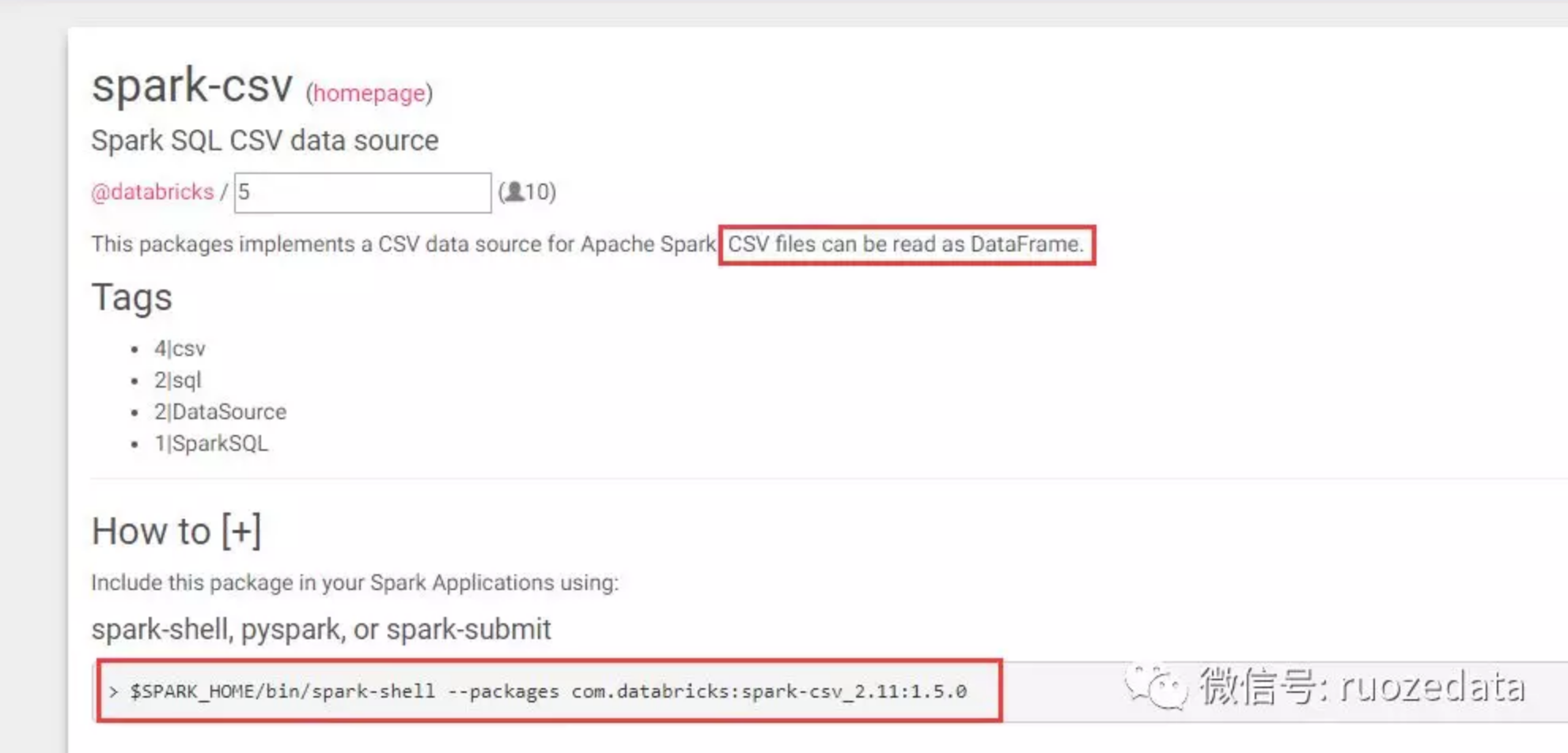

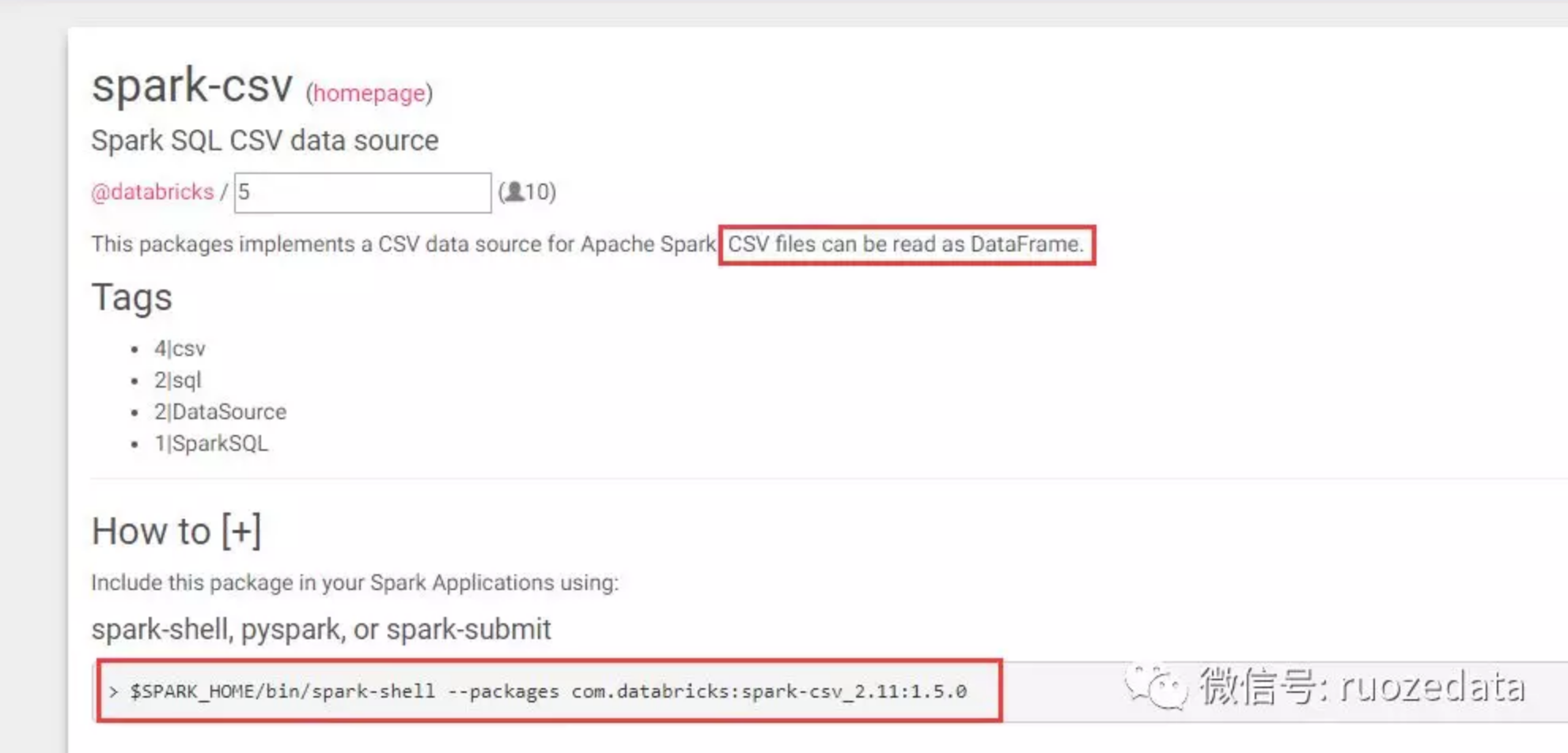

https://spark-packages.org/里有很多third-party数据源的package,spark把包加载进来就可以使用了

csv格式在spark2.0版本之后是内置的,2.0之前属于第三方数据源

ruozedata

https://spark-packages.org/里有很多third-party数据源的package,spark把包加载进来就可以使用了

csv格式在spark2.0版本之后是内置的,2.0之前属于第三方数据源

当Spark程序在运行时,会提供一个Web页面查看Application运行状态信息。是否开启UI界面由参数spark.ui.enabled(默认为true)来确定。下面列出Spark UI一些相关配置参数,默认值,以及其作用。

本文接下来分成两个部分,第一部分基于Spark-1.6.0的源码,结合第二部分的图片内容来描述UI界面在Spark中的实现方式。第二部分以实例展示Spark UI界面显示的内容。

之前呢,我们详细地分析了DAGScheduler的执行过程,我们知道,RDD形成的DAG经过DAGScheduler,依据shuffle将DAG划分为若干个stage,再由taskScheduler提交task到executor中执行,那么执行task的过程,就需要调度器来参与了。

Spark调度器主要有两种模式,也是大家耳熟能详的FIFO和FAIR模式。默认情况下,Spark是FIFO(先入先出)模式,即谁先提交谁先执行。而FAIR(公平调度)模式会在调度池中为任务进行分组,可以有不同的权重,根据权重来决定执行顺序。

那么源码中是怎么实现的呢?

前面介绍了大概的使用语句,接下来讲解基本的功能点的实现。

1 | CREATE TABLE SocketTable( |