若泽数据

CDH5.16.1集群企业真正离线部署(全网最细,配套视频,生产可实践)

视频:https://www.bilibili.com/video/av52167219

PS:建议先看课程视频1-2篇,再根据视频或文档部署,

如有问题,及时与@若泽数据J哥联系。

一.准备工作

1.离线部署主要分为三块:

a.MySQL离线部署

b.CM离线部署

c.Parcel文件离线源部署

2.规划:

| 节点 | MySQL部署组件 | Parcel文件离线源 | CM服务进程 | 大数据组件 |

|---|---|---|---|---|

| hadoop001 | MySQL | Parcel | Activity Monitor | NN RM DN NM |

| hadoop002 | Alert Publisher Event Server | DN NM | ||

| hadoop003 | Host Monitor Service Monitor | DN NM |

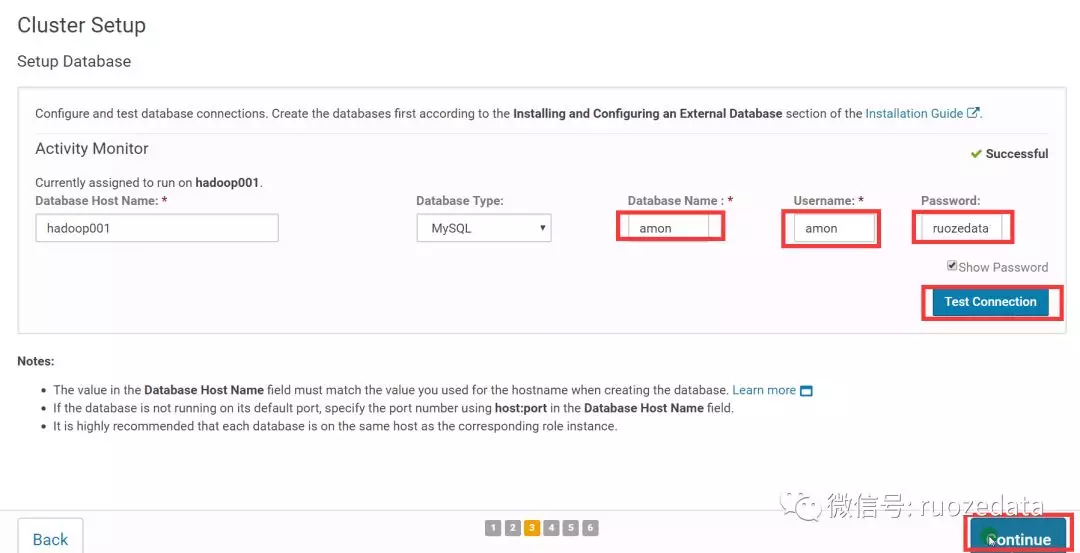

3.下载源:

- CM

cloudera-manager-centos7-cm5.16.1_x86_64.tar.gz - Parcel

CDH-5.16.1-1.cdh5.16.1.p0.3-el7.parcel

CDH-5.16.1-1.cdh5.16.1.p0.3-el7.parcel.sha1

manifest.json JDK

https://www.oracle.com/technetwork/java/javase/downloads/java-archive-javase8-2177648.html

下载jdk-8u202-linux-x64.tar.gzMySQL

https://dev.mysql.com/downloads/mysql/5.7.html#downloads

下载mysql-5.7.26-el7-x86_64.tar.gzMySQL jdbc jar

mysql-connector-java-5.1.47.jar

下载完成后要重命名去掉版本号,

mv mysql-connector-java-5.1.47.jar mysql-connector-java.jar

###准备好百度云,下载安装包:

链接:https://pan.baidu.com/s/10s-NaFLfztKuWImZTiBMjA 密码:viqp

二.集群节点初始化

1.阿里云上海区购买3台,按量付费虚拟机

CentOS7.2操作系统,2核8G最低配置

2.当前笔记本或台式机配置hosts文件

- MAC: /etc/hosts

- Window: C:\windows\system32\drivers\etc\hosts

1 | 公网地址: |

3.设置所有节点的hosts文件

1 | 私有地铁、内网地址: |

4.关闭所有节点的防火墙及清空规则

1 | systemctl stop firewalld |

5.关闭所有节点的selinux

1 | vi /etc/selinux/config |

6.设置所有节点的时区一致及时钟同步

1 | 6.1.时区 |

1 | 6.2.时间 |

7.部署集群的JDK

1 | mkdir /usr/java |

8.hadoop001节点离线部署MySQL5.7(假如觉得困难哟,就自行百度RPM部署,因为该部署文档是我司生产文档)

- 文档链接:https://github.com/Hackeruncle/MySQL

- 视频链接:https://pan.baidu.com/s/1jdM8WeIg8syU0evL1-tDOQ 密码:whic

9.创建CDH的元数据库和用户、amon服务的数据库及用户

1 | create database cmf DEFAULT CHARACTER SET utf8; |

10.hadoop001节点部署mysql jdbc jar

1 | mkdir -p /usr/share/java/ |

三.CDH部署

1.离线部署cm server及agent

1 | 1.1.所有节点创建目录及解压 |

2.hadoop001节点部署离线parcel源

1 | 2.1.部署离线parcel源 |

3.所有节点创建软件安装目录、用户及用户组权限

mkdir -p /opt/cloudera/parcels

chown -R cloudera-scm:cloudera-scm /opt/cloudera/

4.hadoop001节点启动Server

1 | 4.1.启动server |

5.所有节点启动Agent

1 | /opt/cloudera-manager/cm-5.16.1/etc/init.d/cloudera-scm-agent start |

6.接下来,全部Web界面操作

http://hadoop001:7180/

账号密码:admin/admin

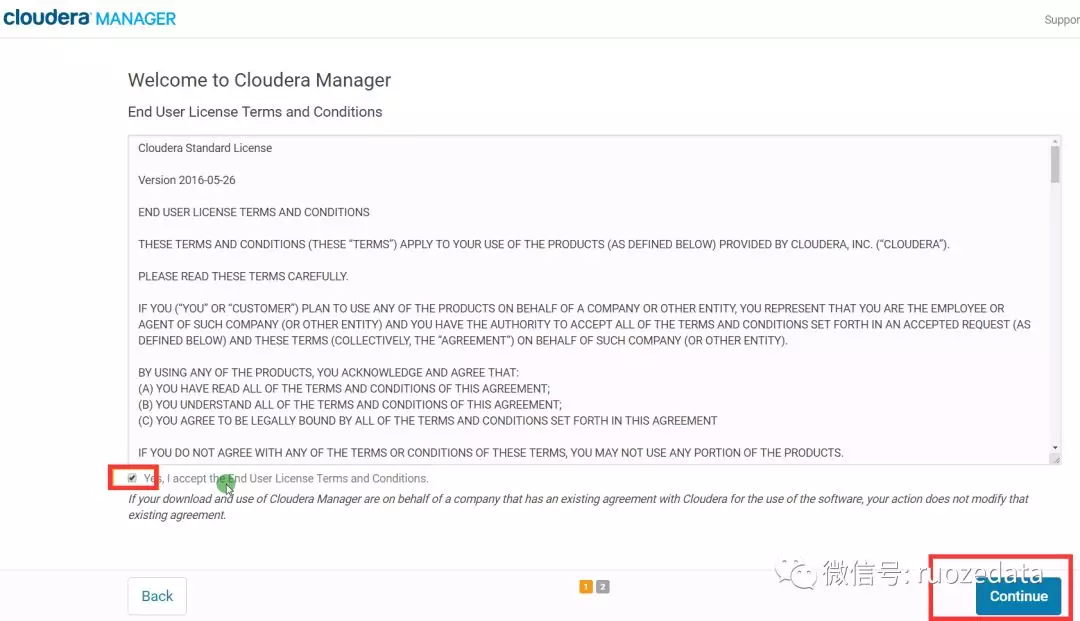

7.欢迎使用Cloudera Manager–最终用户许可条款与条件。勾选

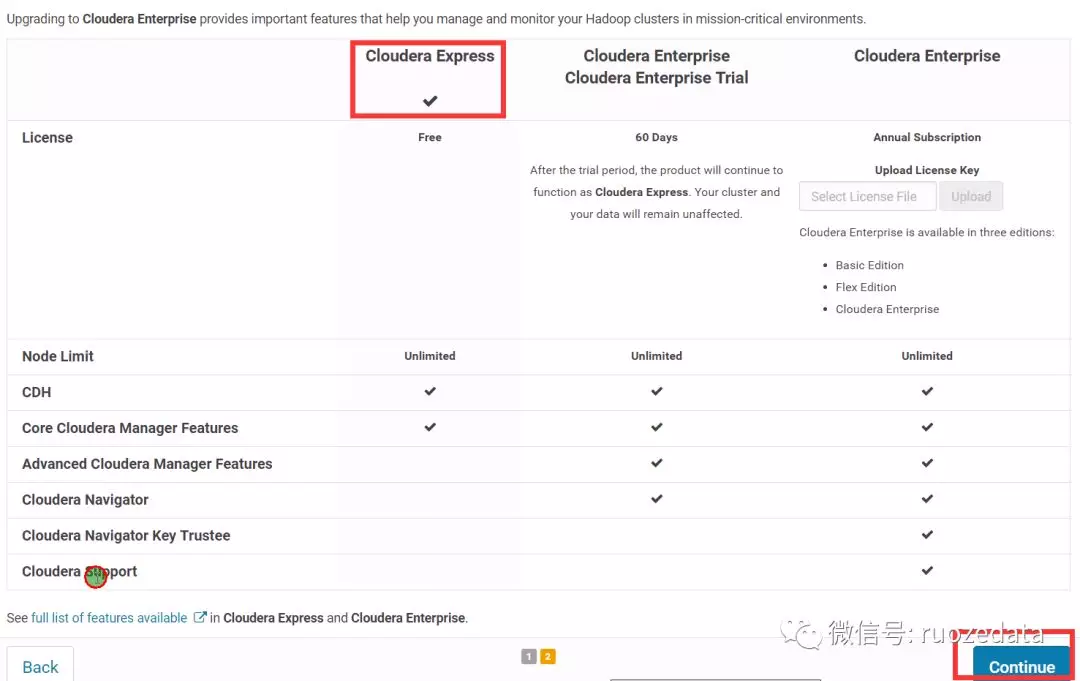

8.欢迎使用Cloudera Manager–您想要部署哪个版本?选择Cloudera Express免费版本

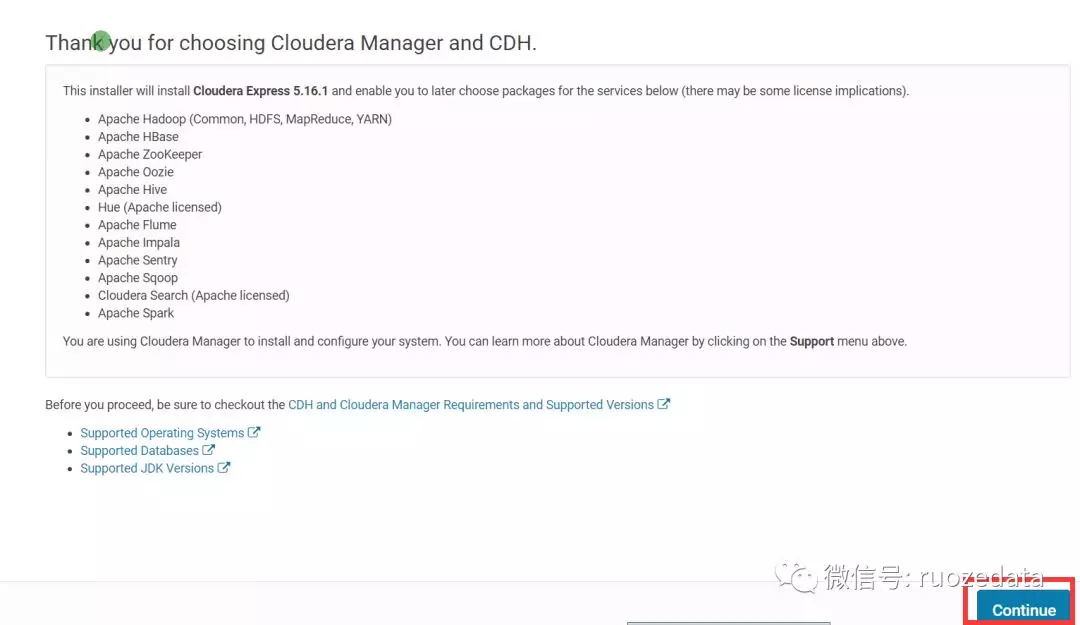

9.感谢您选择Cloudera Manager和CDH

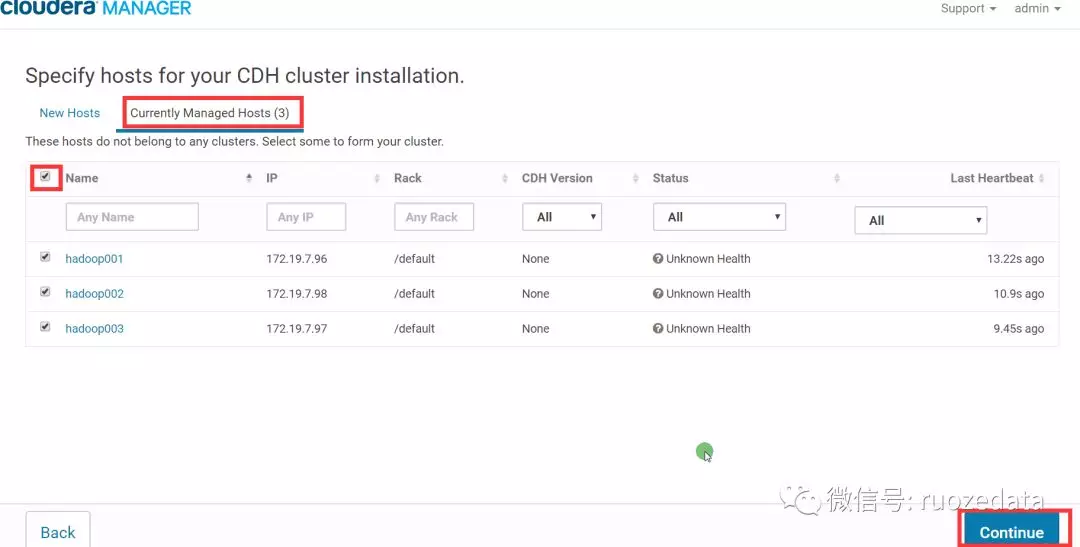

10.为CDH集群安装指导主机。选择[当前管理的主机],全部勾选

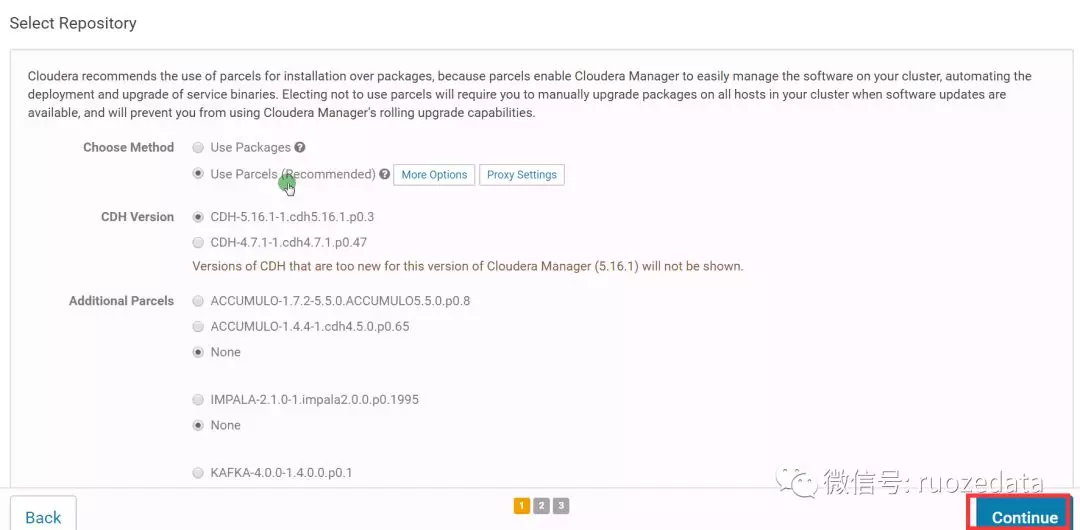

11.选择存储库

12.集群安装–正在安装选定Parcel假如

本地parcel离线源配置正确,则”下载”阶段瞬间完成,其余阶段视节点数与内部网络情况决定。

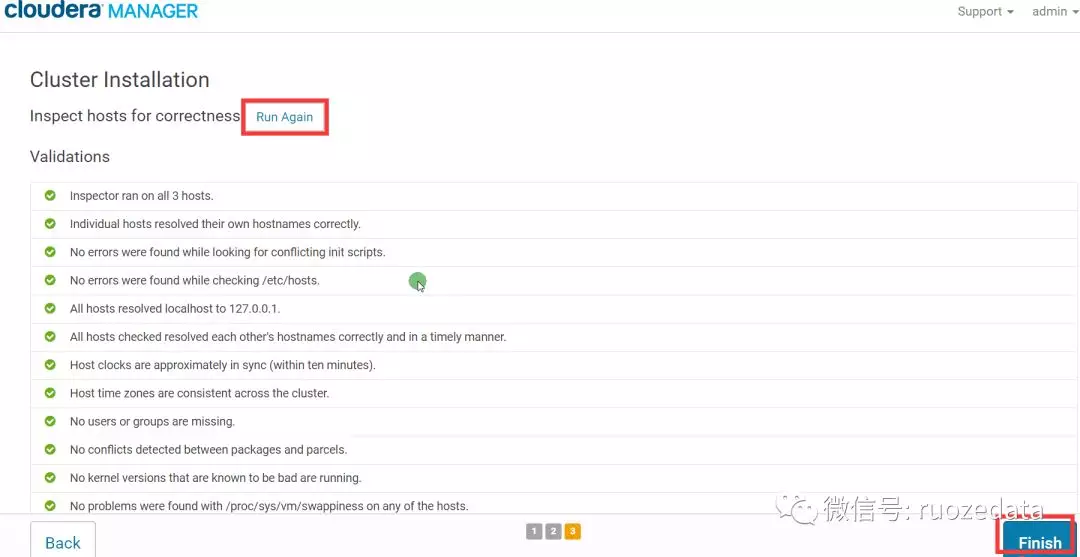

13.检查主机正确性

1 | 13.1.建议将/proc/sys/vm/swappiness设置为最大值10。 |

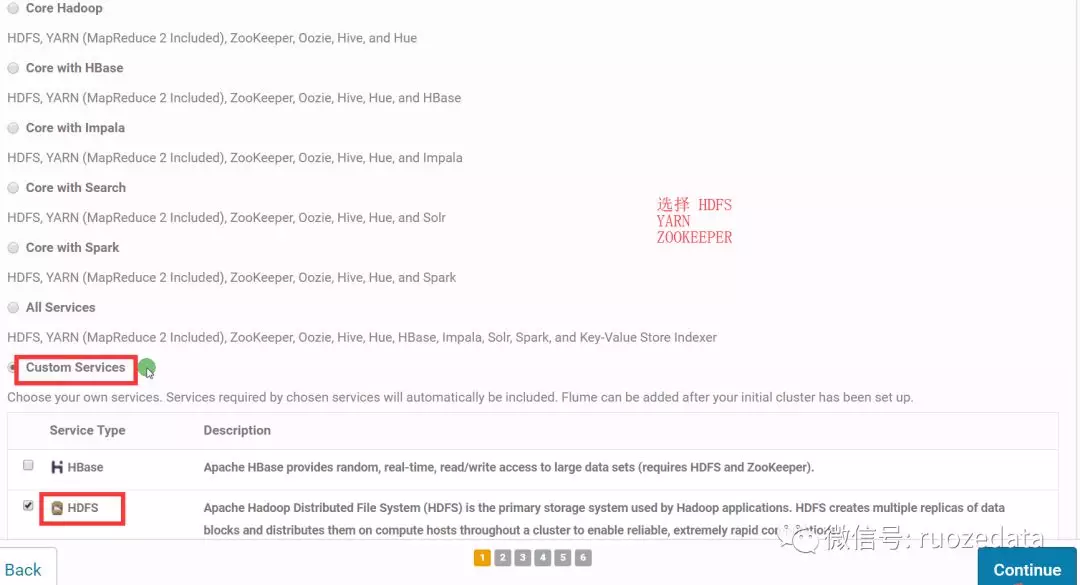

14.自定义服务,选择部署Zookeeper、HDFS、Yarn服务

15.自定义角色分配

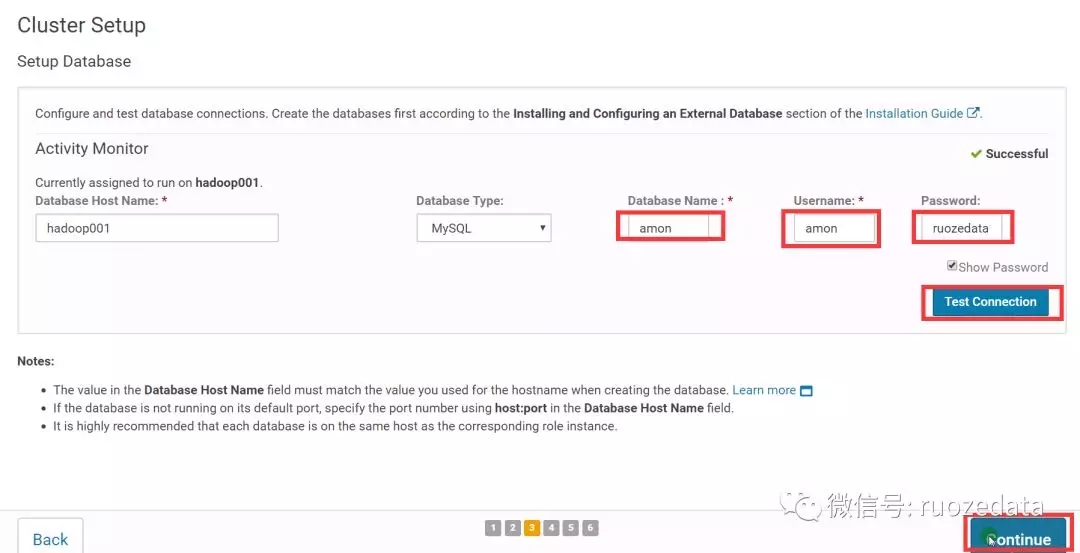

16.数据库设置

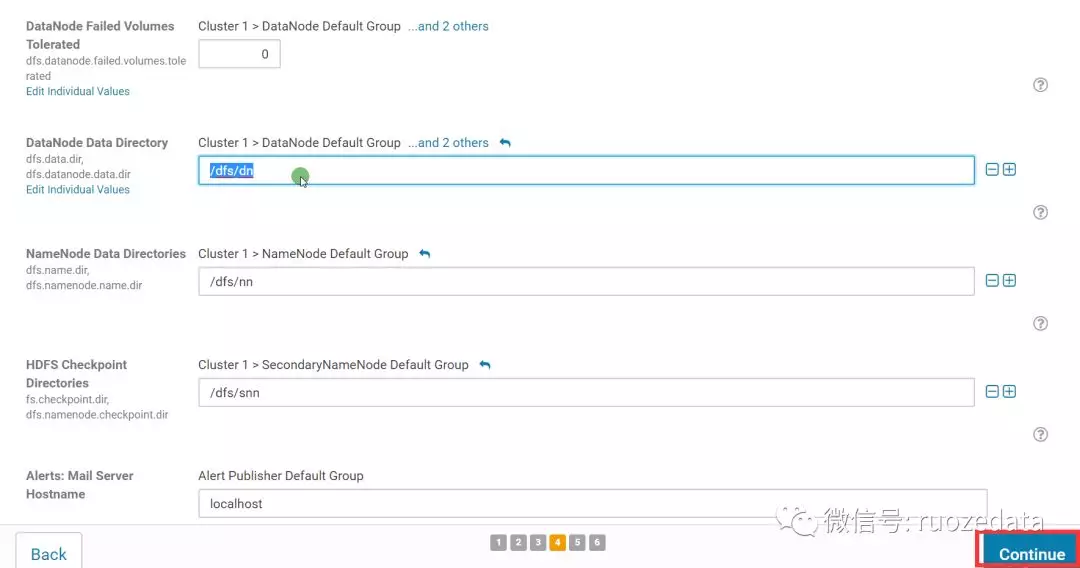

17.审改设置,默认即可

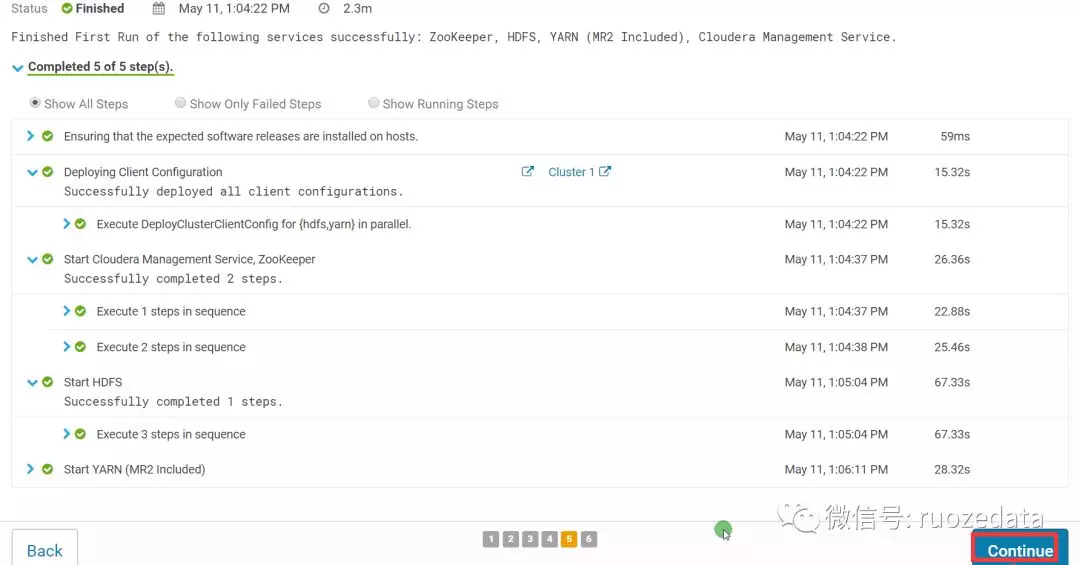

18.首次运行

19.恭喜您!

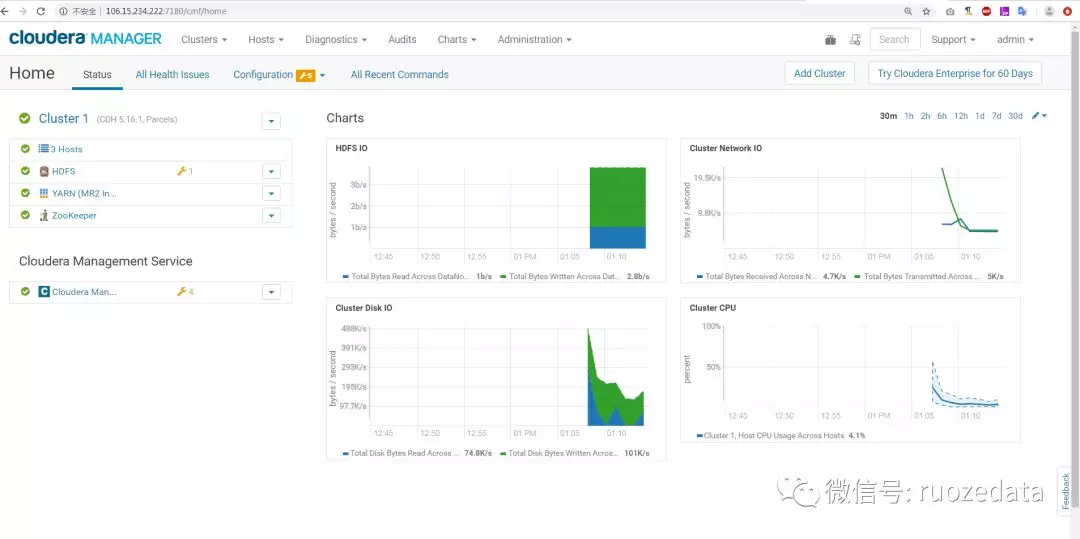

20.主页

CDH全套课程目录,如有buy,加微信(ruoze_star)

1 | 0.青云环境介绍和使用 |

Join us if you have a dream.

若泽数据官网: http://ruozedata.com

腾讯课堂,搜若泽数据: http://ruoze.ke.qq.com

Bilibili网站,搜若泽数据: https://space.bilibili.com/356836323

若泽大数据–官方博客

若泽大数据–博客一览

若泽大数据–内部学员面试题

扫一扫,学一学:

/若泽数据--扫描入口.png)